En 2001, dos científicos de la computación, Pablo Viola y Michael Jones, revolucionaron el campo de la detección de rostros por computador gracias a un algoritmo que podía detectar rostros en una imagen en tiempo real. Era tan rápido y sencillo que pronto fue incorporado como estándar en algunas cámaras y las redes sociales.

La clave fue identificar los elementos más relevantes. Decubrieron que el puente de la nariz por lo general forma una línea vertical más brillante que las cuencas de los ojos cercanos. También notaron que los ojos están a menudo en la sombra y así forman una banda horizontal más oscura.

Concentrándose en estos elementos claves construyeron un algoritmo que busca primero una banda luminosa vertical en una imagen, que podría ser la nariz, y luego bandas oscuras horizontales que podrían ser los ojos, para terminar con algunos otros patrones generales asociados con las caras. Ninguna de estas características es por sí sola muy sugestiva de una cara. Pero cuando se detectan una después de la otra en una cascada, el resultado es una buena indicación de una cara en la imagen. Estas pruebas son muy simples de ejecutar, por lo que el algoritmo resultante puede trabajar de forma rápida en tiempo real.

Pero solo funciona con rostros vistos desde el frente. Ahora, Sachin Farfade y Mohammad Saberian, en los laboratorios de Yahoo en California, y Li-Jia Li, en la Universidad de Stanford, han revelado una solución para detectar caras en ángulo, e incluso cuando están parcialmente ocultas.

Utilizan un enfoque fundamentalmente diferente, basado los últimos avances en un tipo de aprendizaje de máquina conocido como red neuronal convolucional profunda. La idea es formar una red neuronal de muchas capas utilizando una amplia base de datos de ejemplos anotados, en este caso las imágenes de caras desde muchos ángulos. Para ello, crearon una base de datos de 200.000 imágenes que incluyen caras en diversos ángulos y orientaciones y otras 20 millones de imágenes sin caras. Luego capacitaron su red neuronal en lotes de 128 imágenes y más de 50.000 iteraciones.

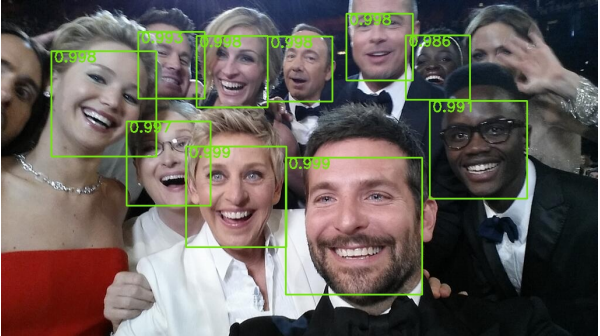

El resultado es el nuevo algoritmo que puede detectar caras en casi cualquier posición, e incluso muchas caras de la misma imagen.

Llamaron a este enfoque "detector de cara densamente profundo" (Deep Dense Face Detector). "Comparamos el método propuesto con otros métodos basados en el aprendizaje profundo y se puso de manifiesto que los resultados son más rápidos y más precisos", dicen.

Este trabajo muestra la rapidez con que está avanzando la detección de rostros, gracias a métodos basados en redes neuronales. La técnica de red neuronal convolucional sólo tiene un par de años y ya ha dado lugar a importantes avances como éste.

Por ahora es aún difícil encontrar imágenes tomadas de personas específicas. Pero es inevitable que esta capacidad llegue a nosotros en un futuro no muy lejano.

La técnica para reconocer las emociones en los rostros también ha avanzadao enormemente. El que más sabe al respecto es Paul Ekman, que ha desarrollado el sistema Facial Action Coding System y confeccionado un catálogo de más de 5.000 movimientos musculares a partir de un profundo análisis, el que muestra como la más sutil arruga que altera la fisonomía de nuestro rostro puede revelar datos muy ocultos sobre el estado emocional de la persona.

Y varias empresas se están especializando en este tipo de análisis con fines comerciales, especialmente de marketing. Así, Emotient grabó las reacciones faciales de miles de personas de etnias muy diferentes, acumulando 90.000 datos extraídos de los fotogramas, para medir las emociones de las personas durante las pruebas de los productos de grandes compañías como Honda Motor y Procter & Gamble. Un investigador de la Universidad de San Diego usa el software para comprobar el nivel de dolor en los niños con apendicitis. También se pueden crear mapas de emociones que podrían ser útiles en el tratamiento de enfermedades mentales. Pero es un terreno resbaladizodado que se desliza hacia la invasión de la privacidad.

Las empresas, ahora, se dirigen a la integración de esta tecnología en los sistemas de vídeo.

Y reconocimiento de otros objetos

Los mismo procedimientos utilizado para identificar rostros pueden usarse para reconocer otros objetos y existe una competencia -basada en el uso de redes neuronales artificiales- para mejorar estos sistemas. Microsoft es uno de los competidores y consigue por ahora una calificación del 29.1%, lo que equivale a que 3 de cada 10 veces sus respuestas son al menos tan buenas como las que podría brindar un humano. La idea es utilizarla para crear subtítulos (pies de fotos). (Google es otro de los competidores.)

Reconiciento de emociones

Las empresas, ahora, se dirigen a la integración de esta tecnología en los sistemas de vídeo.

Y reconocimiento de otros objetos

Los mismo procedimientos utilizado para identificar rostros pueden usarse para reconocer otros objetos y existe una competencia -basada en el uso de redes neuronales artificiales- para mejorar estos sistemas. Microsoft es uno de los competidores y consigue por ahora una calificación del 29.1%, lo que equivale a que 3 de cada 10 veces sus respuestas son al menos tan buenas como las que podría brindar un humano. La idea es utilizarla para crear subtítulos (pies de fotos). (Google es otro de los competidores.)

Fuente: MIT Technology Review, 16/02/2015

TICbeat, 13/02/2015